Voice-Over Clips für Mixed Reality Apps selbst produzieren

Erfahren Sie:

– Warum ein Voice-Over, also eine zusätzliche Audio-Information, wichtig ist.

– Wie Sie ein Voice-Over erstellen und mit Audacity bearbeiten können.

– Wie Sie die Tracks in Unity integrieren.

Stellen Sie sich vor, Sie sollen an einem digitalen Zwilling komplexe Arbeitsschritte durchlaufen und das unter Zeitdruck. Für das Lesen der Aufgabenstellung fehlt Ihnen die Zeit. Mit einem Voice-over nutzen Sie neben den Augen auch die Ohren“. Dadurch können Sie mehr Informationen gleichzeitig und stressfrei aufnehmen, was den Lernerfolg deutlich erhöht.

Trotzdem konzentrieren sich viele Entwickler vor allem auf 3D Art und das Interaktionsdesign, wenn sie an einer HoloLens App für Mixed Reality Erlebnisse arbeiten. Dabei ist die Tonspur ein Schlüsselfaktor für ein überzeugendes Ergebnis.

In diesem Blogbeitrag finden Sie eine einfache Schritt-für-Schritt Anleitung, wie Sie ihren Voice-Over Clip selbst produzieren können. Die Tonspur bringt mehr Spaß in die Mixed Reality App und macht sie leichter zu nutzen.

Warum ist ein Voice-Over so wichtig?

Neben der authentischen Wirkung für die Anwendung ist das Voice-Over als räumlich passendes Audio-Feedback für fast alle User-Interaktionen notwendig. Es ist ein grundlegendes und leider oft übersehenes Mittel, um dem User notwendige Informationen zu geben.

Sind Teams in hochtechnischen oder anders komplexen Bereichen aktiv, neigen sie meist dazu, geschriebenen Text in den Apps anzubieten. Ist jedoch der User visuell auf 3D-Content oder andere interaktive Elemente konzentriert, hilft ihm ein Voice-Over viel mehr. Deshalb profitiert aus unserer Erfahrung jede komplexe HoloLens App von einem zusätzlichen Voice-Over.

Zudem gehört guter Audio-Support laut Microsoft zu den Qualitätskriterien bei der Bewertung einer Mixed Reality App. Hier geht es zum Dokument mit den Kriterien:

Mixed Reality app quality criteria.

Der Voice-Over Clip in 4 Schritten

1. Integrierte Text-to-Speech Funktion nutzen

Wenn wir ein Voice-Over für Windows Mixed Reality erstellen, nutzen wir in der Regel zuerst die in der Software enthaltene Text-to-Speech Funktion. Dafür markieren wir im Unity Editor ausgewählte Text-Snippets, um sie mit den üblichen Windows APIs für Konvertierung in Audio-Dateien zu verwandeln. Das Mixed Reality Toolkit für Unity enthält einen wunderbaren Unity-Wrapper für diese APIs (MRTK TextToSpeech), der hilfreich ist, um mit der Entwicklung von Rapid Prototyping zu beginnen.

Warum Text-to-Speech nicht ausreicht:

– Es gibt nur eine kleine Auswahl an Stimmen, besonders für Sprachen wie Deutsch.

– Die Computerstimmen sind nicht sehr überzeugend. Eine gute Intonation

ist dagegen sehr wichtig, um User zu motivieren, bestimmte Aktionen

auszuführen.

– Es gibt keinen einfachen Weg, um benutzerdefinierte Audioeffekte zu integrieren.

Deshalb empfehlen wir bei der Fertigstellung der App, die Text-to-Speech Passagen durch maßgeschneiderte Voice-Over Clips zu ersetzen. Wir zeigen hier einen einfachen und günstigen Weg, wie wir es geschafft haben, überzeugende Voice-Over Clips ohne die Kenntnisse eines Toningenieurs zu erstellen.

2. Eigene Voice-Over Clips erstellen

Für die Aufnahme und die Bearbeitung der Audio-Tracks benötigt man nur ein angemessenes USB-Mikrofon sowie einen Desktop- oder Tablet-Computer.

Wir nutzen diese Hard- und Software:

- Apogee MiC 96k für iPad, iPhone &Mac

- iPad Pro mit VoiceRecord Pro (kostenlos) für die Aufnahme

- Windows PC mit Audacity (kostenlos) für einfache Audio-Bearbeitung

Man kann zusätzlich einen Poppschutz für das Mikrofon verwenden, um Außengeräusche zu dämpfen.

Die Aufnahme

Wir haben zuerst damit begonnen, mögliche Kandidaten vorsprechen zu lassen. Denn die Stimme und die Art zu sprechen sind Schlüsselfaktoren für ein gutes Voice-Over. Wir wählten dann eine Sprecherin aus. Ihre Stimme ist angenehm und sie bringt Sprech-Erfahrung aus dem Gesangsunterricht sowie von öffentlichen Auftritten mit. Wichtig ist, dass sich die Sprecher-Person wohl dabei fühlt, die eigene Stimme zu hören. Letztlich hängt die Wahl des Sprechers davon ab, wen man in seiner App ansprechen möchte.

Üblicherweise nehmen wir verschiedene Versionen (Takes) desselben Text-Snippets für das Voice-Over auf und exportieren die Audio-Dateien zu Microsoft One Drive. Dafür ist es wichtig, sie in höchstmöglicher Qualität im WAV Format zu speichern, um sie für Microsoft HoloLens nutzen zu können.

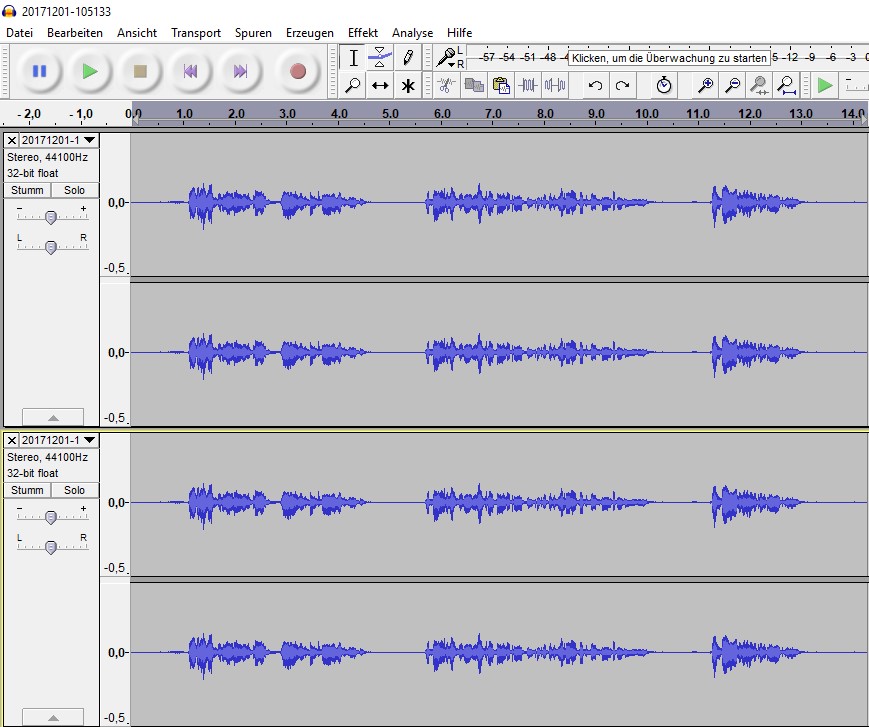

3. Aufnahmen verbessern mit Audacity

Um an den Aufnahmen zu arbeiten, importieren wir sie nach Audacity. Dort wählen wir die brauchbaren Teile der Aufnahme aus und schneiden die ausgewählten Stellen aus. Mit Audacity kann man dann weitere Verbesserungen an der Tonspur vornehmen.

Aufbereitung der Audiodateien

- Zuerst verstärken wir die Lautstärke für alle aufgenommenen Tracks bis sie qualitativ gleich sind. Dafür wählt man aus:

→ Effect → Amplify und hier eine Lautstärke (dB) kurz unter der Standardeinstellung wählen. - Dann nutzen wir Rauschunterdrückung für einen klaren Sound in unserem Clip.

Dafür wählen wir einen Bereich aus, wenn der Sprecher eine Pause zwischen zwei Sätzen macht. Dann wählen wir:

→ Effect → Noise Reduction, hier auf „Get Noise Profile“ klicken. Nun markieren wir den gesamten Track, öffnen das „Noise Reduction“-Fenster wieder und klicken auf OK. Das wiederholen wir für alle Arten von Geräuschen. Dann sollte der Track geräuschfrei sein. - Wer möchte, dass sein Track sich mehr nach einer Stimme wie von Cortana anhört, dupliziert zuerst seinen Track und fügt dann diese zusätzlichen Effekte ein:

- Effect > Change Pitch > Apply Percent Change of around 3 %

• Effect > Change Tempo > Apply Percent change of around 1 %

Das gibt der Aufnahme einen dezenten roboterähnlichen Sound, ohne die Sprachverständlichkeit zu sehr einzuschränken.

Wenn das alles erledigt ist, werden alle Tracks als WAV-Dokument exportiert. Audacity sorgt dafür, dass alle Tracks auch zwei Stereo-Spuren enthalten.

4. Die Integration in Unity

Bevor die Tracks zu Unity importiert werden, müssen die wichtigsten Settings der Audio-Clip Dateien geprüft werden. Weitere Informationen zum Abgleich von Speicherkapazität und Ladezeiten für verschiedene Settings sowie Komprimierungsformate gibt es in den Unity Docs.

Wenn wir unsere Clips für Unity nutzen, erstellen wir in der Regel keine separaten Audioquellen für jeden Clip. Statt dessen richten wir eine bestimmte Audioquelle für Voice-Over ein und verknüpfen dieses mit einem globalen Voice-Manager-Objekt.

Wenn Sie einen Avatar oder Assistenten in Ihrer App nutzen, kann man die Audioquelle auch mit diesem Objekt verknüpfen. Dafür muss man dann ‚Spatial Audio‘ in der Komponente der Audioquelle aktivieren: ‚Spatial Blend‘ → 3D

Es reicht aber auch, eine normale 2D Audioquelle mit konsistentem Sound für die gesamte App zu nutzen.

Viel Erfolg beim 1. eigenen Voice-Over wünscht Ihnen das Team von data experts!